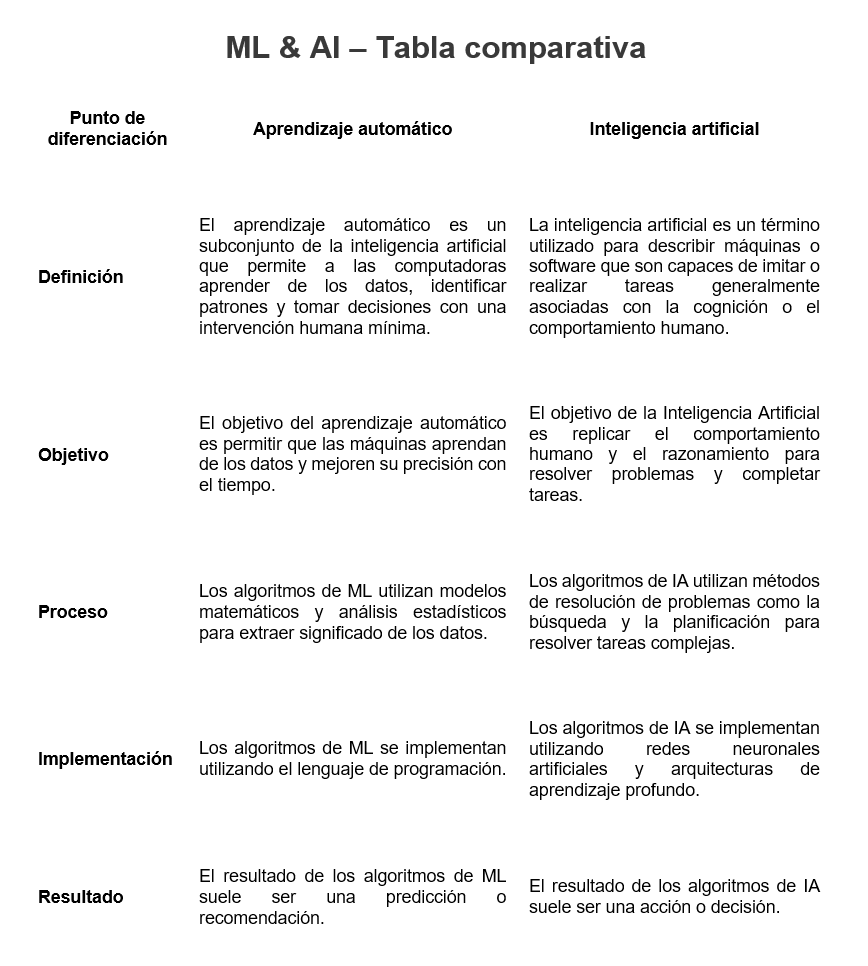

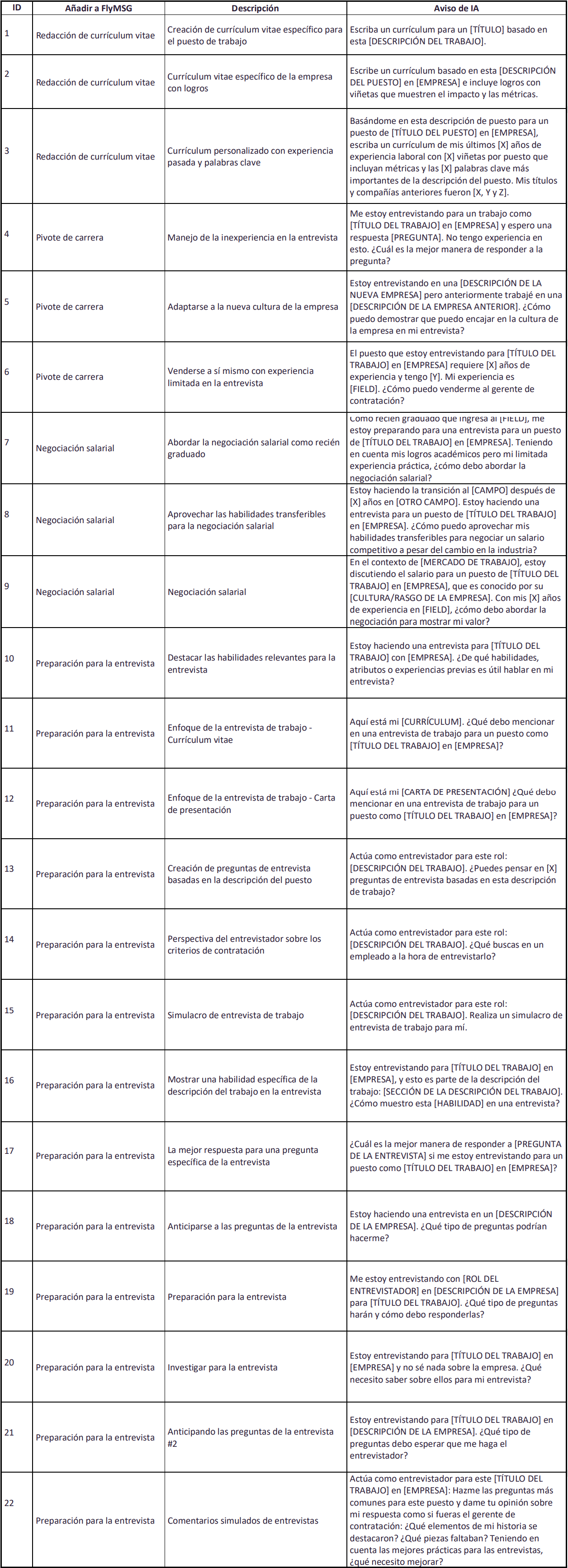

#1. Indicaciones para una Búsqueda de Empleo Efectiva

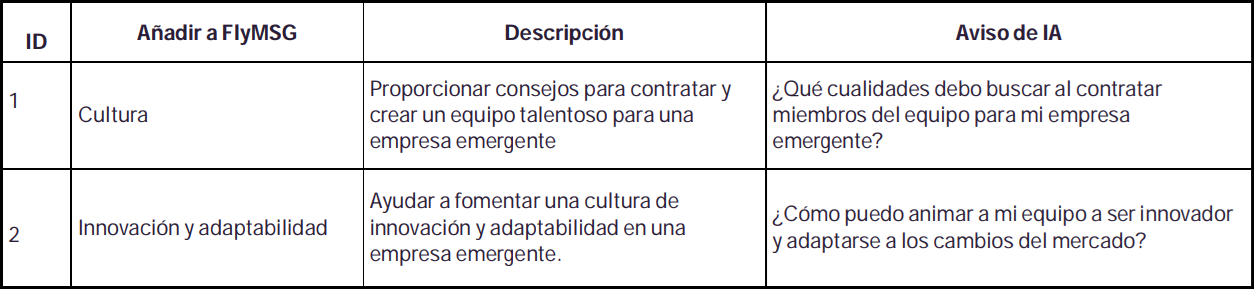

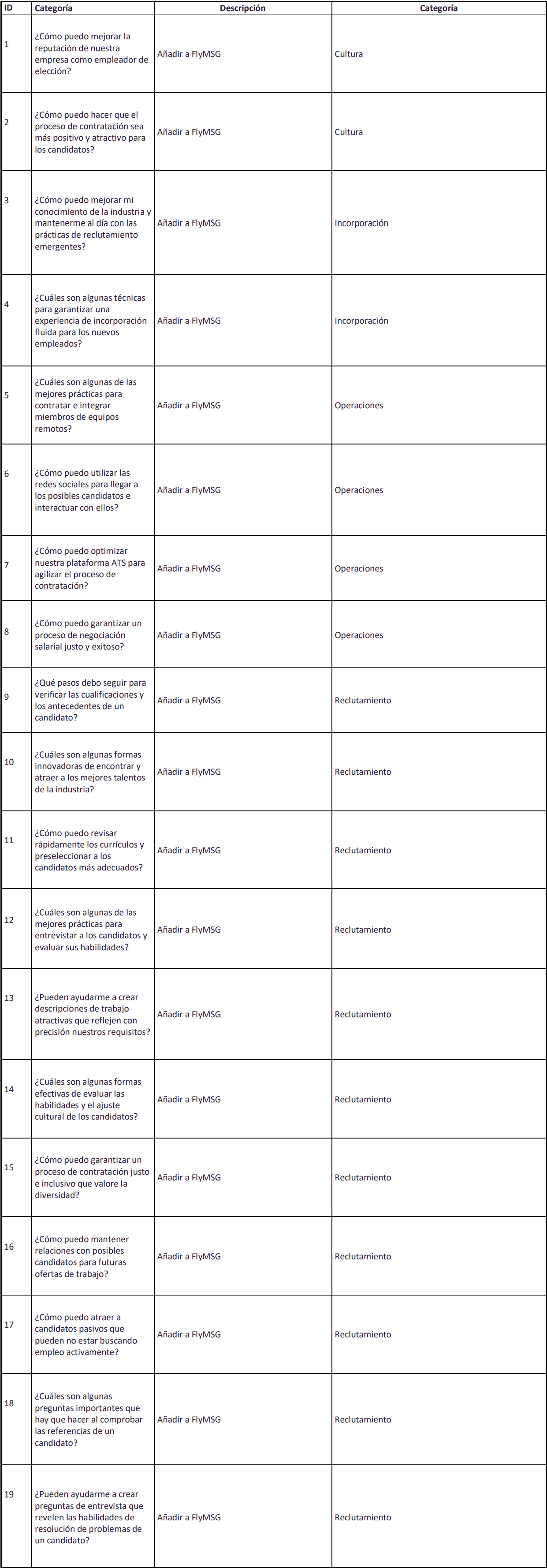

#2. Mejores indicaciones de Chat GPT para recursos humanos y reclutadores

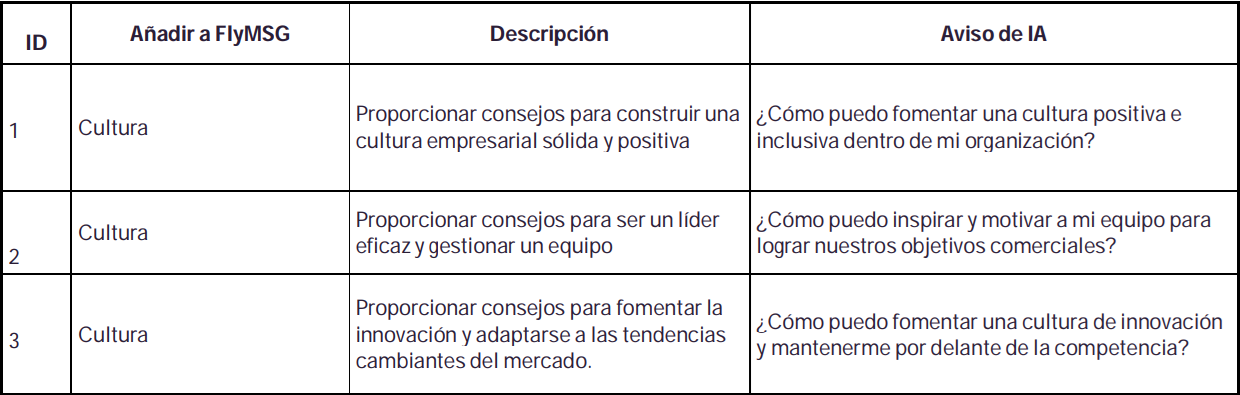

#3. Mejores indicaciones de Chat GPT para que los dueños de negocios hagan las cosas

#4. Mejores indicaciones de Chat GPT para emprendedores